太平洋科技 要闻

国产3D虚拟人版《Her》「杀向」迪拜

量子位

整合编辑:太平洋科技

发布于:2024-10-21 17:33

量子位

整合编辑:太平洋科技

发布于:2024-10-21 17:33

|

好久没出门,AI产品的世界已经快进到这个样子了? 在全球三大IT展之一的GITEX GLOBAL上,量子位在某个展台,先后体验了和Chatbot聊天、用AI创建属于自己的3D数字人形象、和3D形象实时语言、肢体互动。 也就是说,《Her》有了3D虚拟人版。

旁边的展商过来神神秘秘说了句:

量子位还没反应过来,展商又补了一句:

啊……这……我……行吧,有了AI,和人聊天都有预制版了。

如果我说这家展商是个中国公司,也许不少朋友立马能猜出来。 没错,它就是Soul。 量子位在现场拉着Soul的工作人员大聊特聊了一番,其中不仅仅有Soul AI某子板块负责人和他的组员,还被量子位捉到了这家公司的CTO陶明。 |

原创栏目

IT百科

网友评论

聚超值•精选

-

- 海康威视移动固态硬盘1TB外接手机电脑高速2tb mac外置SSD T200N

- 券后省10

-

¥239.0

¥262.1

- 西部数据(WD) Green SSD固态硬盘 SATA3.0接口 西数绿盘 笔记本台式机硬盘 SSD固态硬盘 2TB

- 券后省10

-

¥872.0

¥882.0

- vivo X100s 16GB+256GB 钛色 蓝晶×天玑9300+ 蔡司超级长焦 7.8mm超薄直屏 拍照 AI 手机

- 券后省300

-

¥4099.0

¥4399.0

- 逗映(FUNSNAP)派 手机稳定器 手持云台稳定器 三轴防抖跟拍云台 全域无死角运镜 折叠收纳带三脚架

- 券后省10

-

¥429.0

¥439.0

- 西部数据(WD) 企业级桌面移动硬盘 高速 3.5英寸大容量 兼容Mac 外接硬盘办公数据存储备份 USB3.0/单盘 My BOOK 22TB 官方标配

- 券后省50

-

¥5139.0

¥5189.0

-

- 华为(HUAWEI)Mate60 RS星钻智能视窗保护套保护壳手机壳 玄黑 华为原装原厂

- 券后省20

-

¥1979.0

¥1999.0

- ANKER安克33W桌面充电器适用于苹果14充电头iPhone13/12手机多口多功能排插办公工作室接线板插头 自然青 33W 5口合一 智能温控

- 每满300减40

-

¥109.0

¥119.0

- 宝华韦健(B&W) Px7S2e 无线HIFI头戴式主动降噪蓝牙耳机Bowers&WilkinsPx7二代升级款智能音乐耳麦 潜云灰

- 券后省120

-

¥2329.0

¥2449.0

- AOC 31.5英寸 4K高清 IPS HDR Type-C接口90W TUV爱眼认证 双向旋转升降 出厂校准 电脑显示器 U32N3C

- 券后省10

-

¥2789.0

¥2799.0

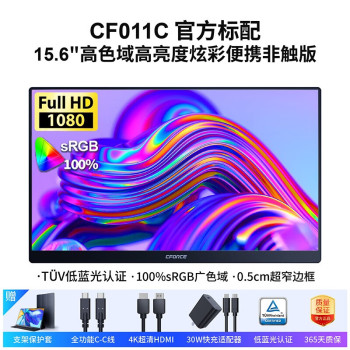

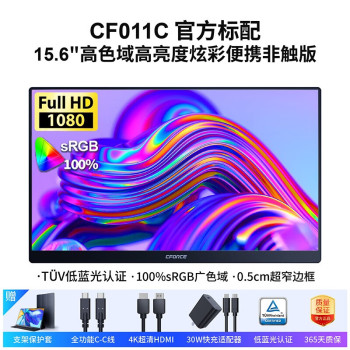

- CFORCE 15.6英寸便携显示器窄边框高色域0坏点原装屏手机电脑显示屏笔记本一线直连switch副屏PS5扩展屏 热销款 FHD IPS 100%色域【11C】

- 券后省230

-

¥539.0

¥769.0

-

- 罗技(Logitech)时尚系列K580无线蓝牙键盘全尺寸轻薄安静舒适ipad手机平板笔记本电脑办公跨屏切换 K580 黑色

- 券后省24

-

¥185.0

¥209.0

- 德国蔡司擦镜纸眼镜镜头手机电脑屏幕清洁湿纸巾200片×1盒除菌

- 券后省15

-

¥118.0

¥159.0

- 腾龙(Tamron)A071 28-200mm 索尼全画幅微单镜头 F/2.8-5.6 Di III RXD大光圈远摄大变焦镜头 圣诞礼物 送礼

- 券后省120

-

¥4419.0

¥4539.0

- 玄派创世魔方旗舰80W高性能办公游戏台式电脑迷你主机 支持PD3.1 140W 原生oculink R7-7840HS/8845HS R7 8845HS 16G 1T

- 券后省200

-

¥3799.0

¥3999.0

- 赛睿(SteelSeries)大师系列Sensei Ten 有线鼠标 电竞游戏鼠标 8键可编程 高敏操控 倾斜追踪 UZI推荐 黑色

- 券后省5

-

¥394.0

¥399.0

-

- 惠威(HiVi)D3.1高保真HIFI书架音响2.0发烧无源音箱组合家用音箱套装 D3.1 + AD-66DPRO(专业版)

- 券后省50

-

¥4829.0

¥4879.0

- BOGASING宝格声G7Pro无线蓝牙音箱便携式移动户外卡拉ok一体机家庭ktv音响套装音响k歌专用低音炮 浩瀚黑【音箱】

- 券后省100

-

¥1299.0

¥1399.0

- Aqara绿米联创智能开关 妙控屏S1E 触屏遥控开关 支持HomeKit 皎月白

- 券后省5

-

¥254.0

¥259.0

- 罗马仕数据线三合一充电线器头一拖三快充车载三头适用苹果16华为Typec安卓多头多功能66W手机iPhone15通用

- 券后省5

-

¥9.9

¥14.9

- 【旗舰店】影石Insta360 Ace Pro/Ace运动相机AI智能摄像摩托

-

¥1598.0

¥2398.0

量子位

量子位

硬件编年史

硬件编年史